Bonjour, je suis à la recherche d’une personne pouvant m’assister dans l’utilisation de l’outil Scrapestorm. Je rencontre actuellement des difficultés à gérer la pagination sur le site de Pôle Emploi. Toute aide serait grandement appréciée !

Je ne comprends vraiment pas cette fascination pour des outils payants (et chinois en occurrence) alors que puppeteer (par google) ou playright(microsoft) sont des outils gratuits et qui sont naturels pour automatiser le navigateur.

Il y a en effet un peu de script basique à écrire, mais il existe également un truc qui s’appelle chatGPT pour ceux qui ne savent pas taper quelques lignes de javascript

Bonjour

Je ne suis pas particulièrement attiré par les produits chinois ou payants, voire les deux à la fois, mais c’est actuellement la solution la plus simple que j’ai trouvée pour récupérer des données, notamment des offres d’emploi. Cela dit, si vous avez une meilleure solution à proposer, je suis ouvert à toute suggestion, surtout que je ne suis pas développeur. Il me faut donc quelque chose de simple et accessible

Bonjour Olivier !

Je ne sais pas si ca pourrait correspondre a votre besoin mais penchez vous sur instant data scraper ainsi que BrowserFlow qui sont 2 outils gratuit !

merci je vais regarder

Bonjour,

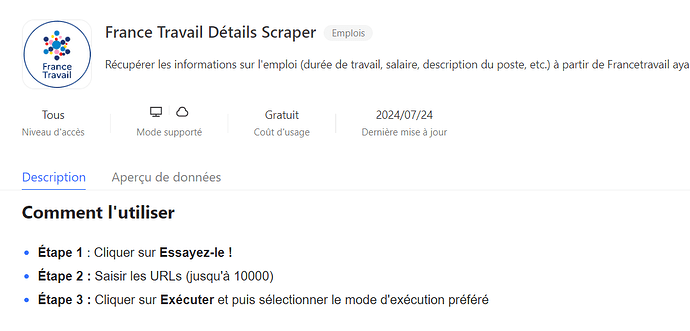

Pourquoi scraper ? Alors qu’il existe une api officielle pour récupérer les offres d’emplois de France Travail.

https://francetravail.io/data/api/offres-emploi

Je suis conscient de l’importance des API, mais je ne les maîtrise pas encore pleinement. Ce n’est pas une compétence que j’ai développée jusqu’à présent, mais je souhaite vraiment m’y former pour élargir mon expertise

Son point sur l’utilisation de l’API est pertinent. Toutefois, il est vrai que si l’on ne maîtrise pas ce type de technologie, cela peut s’avérer complexe. En particulier, l’API de Pôle Emploi peut être difficile à appréhender pour des débutants. Sans entrer dans les détails, il est nécessaire d’effectuer une première requête POST pour obtenir les autorisations, après quoi un jeton est délivré, à utiliser ensuite dans une seconde requête GET avec des paramètres spécifiques. Si un outil de scraping basé sur des extensions no-code fonctionne pour votre besoin, n’hésitez pas à l’utiliser. Sinon, je reste disponible en message privé pour vous aider à automatiser ce processus.